Pensamiento computacional y ChatGPT

Computational thinking and ChatGPT

Barra lateral del artículo

Términos de la licencia (VER)

Esta obra está bajo una licencia internacional Creative Commons Atribución-NoComercial-SinDerivadas 4.0.

Declaración del copyright

Los autores ceden en exclusiva a la Universidad EIA, con facultad de cesión a terceros, todos los derechos de explotación que deriven de los trabajos que sean aceptados para su publicación en la Revista EIA, así como en cualquier producto derivados de la misma y, en particular, los de reproducción, distribución, comunicación pública (incluida la puesta a disposición interactiva) y transformación (incluidas la adaptación, la modificación y, en su caso, la traducción), para todas las modalidades de explotación (a título enunciativo y no limitativo: en formato papel, electrónico, on-line, soporte informático o audiovisual, así como en cualquier otro formato, incluso con finalidad promocional o publicitaria y/o para la realización de productos derivados), para un ámbito territorial mundial y para toda la duración legal de los derechos prevista en el vigente texto difundido de la Ley de Propiedad Intelectual. Esta cesión la realizarán los autores sin derecho a ningún tipo de remuneración o indemnización.

La autorización conferida a la Revista EIA estará vigente a partir de la fecha en que se incluye en el volumen y número respectivo en el Sistema Open Journal Systems de la Revista EIA, así como en las diferentes bases e índices de datos en que se encuentra indexada la publicación.

Todos los contenidos de la Revista EIA, están publicados bajo la Licencia Creative Commons Atribución-NoComercial-NoDerivativa 4.0 Internacional

Licencia

![]()

Esta obra está bajo una Licencia Creative Commons Atribución-NoComercial-NoDerivativa 4.0 Internacional

Contenido principal del artículo

Resumen

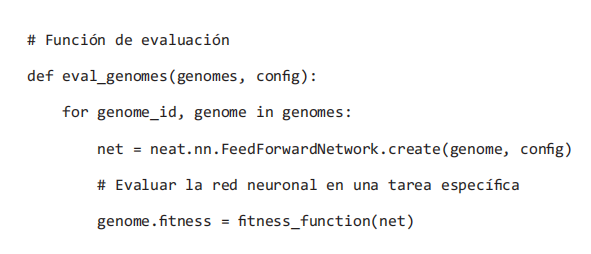

Con el advenimiento de los modelos de procesamiento del lenguaje natural, forma en que solemos referirnos al lenguaje humano, de tipo Large Language Models (LLM), como Bidirectional Encoder Representations from Transformers (BERT), Language Model for Dialogue Applications (LaMDA), Large Language Model Meta Artificial Intelligence (LLaMA), o el tan nombrado Generative Pre-trained Transformers (GPT), se comienzan a generar entre sus usuarios, y el público en general, cualquier cantidad de especulaciones y expectativas acerca de sus alcances, y se comienzan también a explorar nuevas formas de uso, algunas realistas, otras creativas, y otras rayando en la fantasía. El Pensamiento Computacional no es la excepción en esta tendencia. Ésta es la razón por la cual es de suma importancia tratar de elaborar una visión clara acerca de esta innovadora tecnología, buscando evitar la creación y propagación de mitos, que lo único que hacen es enrarecer la percepción y comprensión que se tiene, y tratar de hallar el justo medio en cuanto a los alcances que pueden tener este tipo de tendencias tecnológicas, y las formas de uso que se les puede dar, con especial énfasis en el Pensamiento Computacional. En el presente artículo presentamos un breve análisis sobre lo que es Generative Pre-trained Transformer, así como algunas reflexiones e ideas sobre las formas en que los Large Language Models pueden influir al Pensamiento Computacional, y sus posibles consecuencias. En especial, en este documento, se analiza el conocido ChatGPT, del cual se presenta una valoración sobre las salidas de texto generadas, y su credibilidad para su uso en tareas de uso común para el Pensamiento Computacional, como lo es el realizar un algoritmo, su código y resolver problemas lógicos.

Descargas

Detalles del artículo

Referencias (VER)

Anthony, L.F.W., Kanding, B. and Selvan, R. (2020). Carbontracker: Tracking and predicting the carbon footprint of training deep learning models. arXiv preprint arXiv:2007.03051.

Champollion, J.F. (1828). Précis du système hiéroglyphique des anciens Egyptiens, ou Recherches sur les éléments premiers de cette écriture sacrée, sur leurs diverses combinaisons, et sur les rapports de ce système avec les autres méthodes graphiques égyptiennes avec un volume de planches. Imprimerie royale.

Dalby, A. (2019). Rosetta Stone. WikiJournal of Humanities, 2(1), p.1. https://doi.org/10.15347/wjh/2019.001.

Denning, P.J. and Tedre, M. (2019). Computational thinking. MIT Press.

Devlin, J., Chang, M.W., Lee, K. and Toutanova, K. (2018). Bert: Pre-training of deep bidirectional transformers for language understanding. arXiv preprint arXiv:1810.04805.

Eisenstein, J. (2018). Natural language processing. Available at: https://princeton-nlp.github.io/cos484/readings/eisenstein-nlp-notes.pdf [Accessed 14 June 2022].

Jumper, J. et al. (2021). Highly accurate protein structure prediction with AlphaFold. Nature, 596(7873), pp.583-589. https://doi.org/10.1038/s41586-021-03819-2.

Lodi, M. and Martini, S. (2021). Computational Thinking, Between Papert and Wing. Science & Education, 30(4), pp.883-908. https://doi.org/10.1007/s11191-021-00202-5.

Mikolov, T., Chen, K., Corrado, G. and Dean, J. (2013). Efficient estimation of word representations in vector space. arXiv preprint arXiv:1301.3781.

Mikolov, T., Sutskever, I., Chen, K., Corrado, G.S. and Dean, J. (2013). Distributed representations of words and phrases and their compositionality. Advances in neural information processing systems, 26.

Quiroz-Castellanos, M., Cruz-Reyes, L., Torres-Jimenez, J., Gómez, C., Huacuja, H.J.F. and Alvim, A.C.F. (2015). A grouping genetic algorithm with controlled gene transmission for the bin packing problem. Computers & Operations Research, 55, pp.52-64. https://doi.org/10.1016/j.cor.2014.10.010.

Radford, A., Wu, J., Child, R., Luan, D., Amodei, D. and Sutskever, I. (2019). Language models are unsupervised multitask learners. OpenAI blog, 1(8), p.9.

Stanley, K.O. and Miikkulainen, R. (2002). Evolving Neural Networks through Augmenting Topologies. Evolutionary Computation, 10(2), pp.99-127. https://doi.org/10.1162/106365602320169811.

Vaswani, A. et al. (2017). Attention is all you need. Advances in neural information processing systems, 30.

Wertheimer, T. (2022). Blake Lemoine: Google despide al ingeniero que aseguró que un programa de inteligencia artificial cobró conciencia propia. BBC News, 23 July.

PDF

PDF

FLIP

FLIP